딥러닝(Deep Learning)

- 머신러닝 기법 중 하나인 인공신경망(Artificial Neural Networks) 기법의 은닉 층(Hidden Layer)을 깊게 쌓은 구조를 이용해 학습하는 기법

- 장점 : 데이터의 특징을 단계별로 추상화를 높여가면서 학습할 수 있습니다.

- 얕은 은닉층은 점, 선, 면과 같은 추상화 단계가 낮은 특징을 학습

- 깊은 은닉층은 얼굴의 눈, 코, 입 등 추상화 단계가 높은 특징 을 학습합니다.

특징 학습(Feature Learning)

- 은닉 층을 통한 학습으로 표현 학습(Representation Learning)이라고도 부릅니다.

- Hand-Crafted Feature(손으로 정제한 특징) : 머신러닝 외의 전통적인 기법들은 전문가들의 공식이나 연구로 나온 알고리즘을 통해 추출

- Learned-Feature(학습된 특징) : 학습 과정에서 은닉 층이 쌓여가면서 자동으로 추출

딥러닝이 모든 상황에서 다 좋은가?

- 스스로 모든 특징을 학습하는 딥러닝의 경우가 모든 상황에서 더 잘 쓰이는 것이 아닌가?

- 그렇지 않다.

- 딥러닝 영역 : 자연어, 음성 등의 비정형화된 대량의 데이터를 인식하는 분야에서 잘 동작

- 딥러닝이 약한 영역 : 데이터가 부족한 분야, 정형화된 데이터에 대해서는 상대적으로 잘 동작하지 않는다.

왜 다시 딥러닝이 유행하게 되었는가?

20세기 이미 딥러닝이 유행했던 적이 있었습니다. 이때 많은 딥러닝과 관련된 기본 개념이 정립되었습니다. 하지만 당시의 데이터 양과 컴퓨터 환경 등의 이유로 적용하지 못하고 수그라들었지만 최근 많은 컴퓨터(GPU)의 발전과 많은 양의 데이터(빅데이터)가 쌓여 딥러닝 알고리즘을 학습하기 위한 조건이 충족되면서 다시 붐을 일으켰습니다.

딥러닝 주요 응용분야

- 컴퓨터 비전(Computer Vision) : 인간의 시각 기능을 컴퓨터가 수행 가능하도록 하는 분야

- 물체 인식 등

- CNN

- NLP(Natural Language Processing) : 인간의 언어를 사용할 수 있도록 하는 분야

- 문장 분류, 기계 번역, 챗봇, 이미지 캡셔닝

- RNN 구조 많이 사용

- Speech Recognition : 인간의 음성인식을 수행하는 분야

- STT(Speech to text), 가상비서

- Game : 게임 환경을 이용해서 인공지능 기술 발전하는 연구 분야

- Generative Model : 학습 데이터를 기반으로 새로운 데이터 생성

생물학적 뉴런(feat. BNN)

더보기

출처: Biological Neuron : Robert Schalkoff (aistudy.com)

구조

- 수상돌기, 축삭돌기

- 축삭끝가지(종말가지)

- 시냅스 말단(연접전종말)

- Action potential(AP) : 뉴런이 발생하는 짧은 전기 자극

- 신경전달물질 : AP가 축삭돌기를 따라 이동하여 시냅스가 신경전달물질이라는 화학적 신호 발생

보통 수십억 개로 구성된 거대한 네트워크로 조직되어 있으며 간단한 구조로 복잡한 사고가 가능합니다.

이를 BNN 구조라 하며 해당 구조는 계속 연구중이라고 합니다.

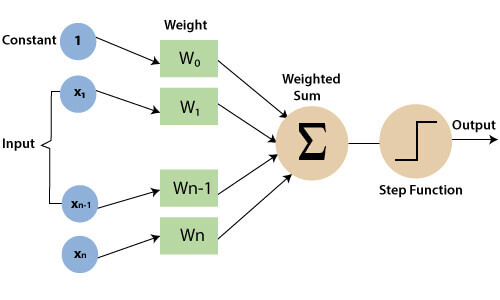

퍼셉트론

- 가장 간단한 인공 신경망 구조

- 층이 1개뿐인 TLU로 구성

- TLU(threshold logic unit)이나 LTU(Linear threshold unit)이라 불리는 인공 뉴런을 기반으로 한다.

- 입력과 출력은 이진이 아닌 숫자이며, 입력의 가중치 합한 후 계단 함수(Step function)을 적용한다.

- Heaviside step function : 가장 널리 사용되는 계단 함수

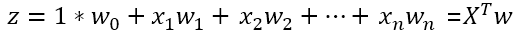

가중치 합:

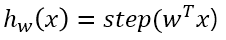

계단 함수: step(z)

출력:

용어:

- 완전 연결 층(Fully connected layer) or 밀집 층(Dense layer) : 현재 층의 모든 뉴런이 이전 층의 모든 뉴련과 연결

- 입력 뉴런(Input neuron) : 퍼셉트론의 입력, 어떤 입력이 들어오든 바로 출력으로 내보낸다.

- 입력 층(Input layer) : 모두 입력 뉴련으로 구성되어있다.

- 편향(Bias): 편향 특성으로 항상 1을 출력(Constant)

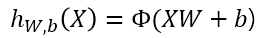

완전 연결 층 출력

- X: 입력 특성의 행렬

- W: 편향 뉴련을 제외한 모든 연결 가중치

- b: 편향 벡터, 편향 뉴런과 인공 뉴런 사이의 모든 연결 가중치 포함

- activation function : 활성화 함수, 인공 뉴련이 TLU이면 Step function이다.

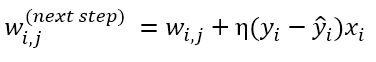

학습 방식

- 서로 활성화 되는 세포가 서로 연결된다.

- 최적의 가중치를 찾는 방식입니다.

- 잘못된 예측을 하는 모든 출력 뉴런에 대해 올바른 예측을 만들 수 있도록 입력에 연결된 가중치를 강화시킨다.

- w(i,j): i번째 입력 뉴런과 j번째 출력 뉴런 사이를 연결하는 가중치

- η: 학습률

- y(i): 현재 훈련 샘플의 j번째 출력 뉴런의 타깃값

- y(^, j): 현재 훈련 샘플의 j번째 출력 뉴런의 출력값

퍼셉트론 수렴 이론

퍼셉트론는 복잡한 패턴을 학습하지 못하지만 훈련 샘플이 선형적으로 구분될 수 있다면 알고리즘이 층을 쌓을 수록 정답에 수렴합니다.

다중 퍼셉트론(MLP)

- 기존 퍼셉트론 : XOR 분류 문제를 해결하지 못한다.

- 즉 선형 분리 불가능

- 이를 해결하기 위해 나온 것이 MLP

'인공지능' 카테고리의 다른 글

| 딥러닝 - 다중 퍼셉트론 (0) | 2022.03.21 |

|---|---|

| 딥러닝 - 로지스틱 & 소프트맥스 & 크로스 엔트로피 (0) | 2022.03.15 |

| 딥러닝 - 다항 회귀 (0) | 2022.03.15 |

| 딥러닝 - 머신러닝 기본 프로세스 (0) | 2022.03.14 |

| 기초 (0) | 2022.03.07 |